Crawl Budget

Als Crawl Budget wird die maximale Anzahl an Seiten verstanden welche der Googlebot bzw. ein anderer Crawler von einer einzelnen Domain erfasst. Dieser Wert ist nicht statisch und variiert von Domain zu Domain. Die maximale Anzahl an crawlbaren Seiten wird dabei von unterschiedlichen Faktoren bestimmt. Ziel eines jeden Unternehmens muss es sein, seine Webseite so zu gestalten, dass der User als auch der Crawler jede Unterseite in maximal 3 Klicks erreicht. Dies kann durch eine möglichst flache Informationsarchitektur und der gezielten Steuerung des Crawlers erreicht werden. Durch den Ausschluss von Unterseiten kann der Crawler zu relevanten Inhalten geführt werden. Je mehr Crawl Budget vorhanden ist, desto mehr Webseiten können durch den Crawler erfasst werden.

Inhaltsverzeichnis

Welche Faktoren beeinflussen das Crawl Budget?

Die nachfolgenden Faktoren beeinflussen das Crawl Budget einer Webseite:

- Alter der Domain: Je älter eine Domain ist, desto mehr Domain Trust wird dieser von Google oder auch anderen Suchmaschinen zugewiesen. Mit steigendem Trust steigt auch die Crawltiefe.

- Link Juice: Starke eingehende Backlinks sind ein wichtiger Indikator welche das Budget positiv beeinflussen können. In diesem Zusammenhang werden vor allen Dingen Links belohnt welche einen hohen Trust inne habe. Dies können z.B. Backlinks von Universitäten oder Zeitungen sein. Solche Links werden als besonders vertrauenswürdig eingestuft und zahlen somit auf das Crawl Budget ein.

- Content: Umfang und Freshness von digitalen Inhalten. Hiermit ist sowohl die Gesamtzahl von Dokumenten gemeint, welche Indexierbar sind, als auch der Intervall in dem neue Inhalte auf der Webseite eingespielt werden.

- Priorisierung von Content: Wichtige Inhalte sollte sowohl intern als auch extern die meisten Verlinkungen erhalten. Dies hilft dem Crawler dabei wichtige Dokumente schnell zu erkennen und zu verarbeiten.

- Steuerung Indexierung: Nicht alle Seiten müssen und sollen in den Index einer Suchmaschine. Durch gezieltes Ausschließen von Unterseiten oder ganzen Subdomains ist es möglich den Crawler gezielt zu relevanten Inhalten zu leiten.

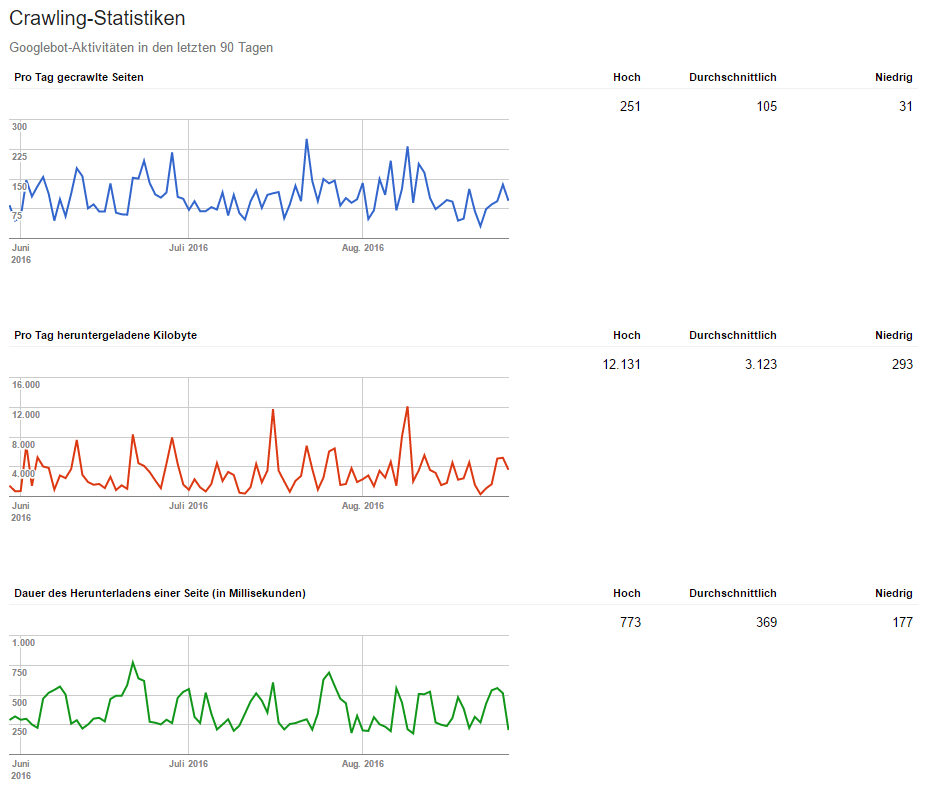

- Geschwindigkeit: Google mag schnelle Webseiten. Daher sollte es für jeden Webmaster eine Pflicht sein, die eigene Webseite so schnell es geht auszuliefern. Mittels des Tools “Page Speed Insight” von Google https://developers.google.com/speed/pagespeed/insights/ kann die eigene Webseite getestet werden. Der Pagespeed Wert sollte jedoch nur eine sekundäre Rolle spielen, primär sollte die reale Ladezeit der Webseite optimiert werden.

Basierend auf dem PageRank-Konzept ist zu sagen, dass je höher der PageRank einer Seite ist, desto mehr Crawl Budget wird dieser zur Verfügung gestellt. Auch wenn der PageRank aktuell nicht mehr in der Toolbar aktualisiert wird, so basiert der Algorithmus von Google noch immer auf diesem. Daher beeinflussen alle Faktoren die den PageRank positiv verändern, auch das Crawl Budget.

Welche Seiten gehören nicht in den Index

Um das begrenzte Crawl Budget effizient nutzen zu können, sollten nur Seiten im Index der Suchmaschine sein, die für die Nutzer einen Mehrwert bieten. Mehrwert definiert sich in diesem Fall über Content und vor allen Dingen über Content der Verkaufen kann. Somit fallen auf einer Webseite bereits viele Unterseiten heraus.

Wie sind Seiten auszuschließen?

Exkurs: Eine Webseite wird optimaler Weise mittels der meta-robots Angabe ausgeschlossen.

<meta name=”robots” content=”noindex”/>

Die folgenden Möglichkeiten bieten sich dabei:

- noindex: Die Webseite wird nicht in den Index der Suchmaschine aufgenommen. Links auf der Seite wird jedoch gefolgt, sowohl Intern, als auch Extern.

- nofollow: Inhalte werden von Google indexiert, jedoch wird den internen, als auch externen Links auf der Webseite nicht gefolgt.

- noindex, nofollow: Webseite wird nicht in den Index der Suchmaschine aufgenommen und Links auf der Seite wird nicht gefolgt.

Des Weiteren gibt es rein technisch die Möglichkeit Seiten über die robots.txt auszuschließen. Der Ausschluss über meta-robots im Head der Seite sollte jedoch immer Vorrang erhalten. Exkurs Ende.

Die folgenden Seiten sollten immer aus dem Index der Suchmaschinen ausgeschlossen werden um Crawl Budget nicht unnötig zu verbrauchen:

- Rechtliche Informationen: Seiten wie das Impressum, die AGB oder der Datenschutz. Diese Seiten erhalten oftmals Links aus dem Footer der Webseite, sind somit im internen Webseitekonstrukt als sehr relevant eingestuft, enthalten jedoch keine bis sehr wenig Informationen für einen Suchenden.

- Leere Kategorie oder Tag-Seiten: Sobald Tag- oder auch Kategorie-Seiten keinen eigenen Inhalt aufweisen, sollten diese aus dem Index der Suchmaschine genommen werden. Ebenfalls sollten Seiten welche Content nur aggregieren ausgeschlossen werden. Wichtig zu wissen ist, dass eine Produktübersicht in einer Kategorie noch keinen eigenen Inhalt darstellt. Der eigentlich Inhalt stammt hier aus einer weiteren Ebene, nämlich der Produktebene. Bei Filtern sollte ebenfalls darauf geachtet werden diese zu nicht indexieren zu lassen, es sei denn die Filterseite enthält eigenen Inhalt (Stichwort Keyword Skalierung).

- kryptische URLs: URL die keine sprechende URL inne haben, sollten grundsätzlich aus dem Index der Suchmaschinen genommen werden. In diesem Zusammenhang sollte auch nur eine Version der Webseite im Index erscheinen, entweder http oder https (bzw. www oder non-www).

- Interne Suchergebnisse: Suchergebnisse haben grundsätzlich nicht im Index einer Suchmaschine verloren. Dies wird auch von Google selbst so vorgeschrieben. Daher sollten alle internen Suchergebnisse deindexiert werden.

Bedeutung für die Suchmaschinenoptimierung

In der Suchmaschinenoptimierung (SEO) ist die Crawl-Optimierung ein Teilgebiet dieser geworden. Ziel ist es den Crawler dahingehend zu steuern, das nur Seiten mit hoher Qualität und Gewichtung (Suchvolumen) gecrawlt werden bzw. diese zuerst in den Index aufgenommen werden. Wenig wichtigere Seiten oder solche mit einem sehr geringem Suchvolumen können somit einen längeren Klickpfad erhalten. Somit stellt das Crawl Budget und dessen Optimierung einen essentiellen Baustein der Suchmaschinenoptimierung dar, welcher großen Einfluss auf die gesamte Informationsarchitektur einer Webseite hat.